开云kaiyun官方网站但它并不是独一的方法-反波胆·软件

发布日期:2024-11-25 05:09 点击次数:111

剪辑:桃子 好困

【新智元导读】Scaling Law并未失效,仅仅不再局限于参数领域的增多。MIT团队最新臆测发现,测试时历练在Scaling大模子上,融会出破损性后劲,ARC众人基准测试中拿下61.9%收货,忘形东谈主类选手。

OpenAI被曝出下代旗舰模子Orion进展冷静,里面缔造团队大改目的,一技能在全网掀翻庞大的风暴。

大模子Scaling Law撞墙了、失效了....各种论调甚嚣尘上,OpenAI大牛不得不下场躬行提拔这场被怀疑论淹没的时势。

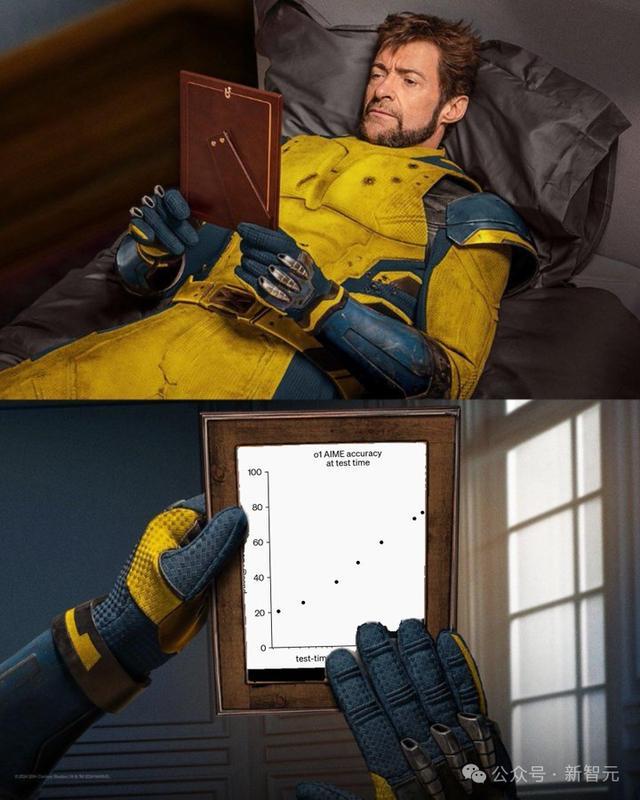

他们笃定的是,推理/测试时打算(test-time compute),是Scaling大模子另一个「齿轮」。

好巧不巧,MIT团队最新力作又延展了o1 Scaling路子,解释了「测试时历练」(TTT)能够让模子性能暴涨。

论文地址:https://ekinakyurek.github.io/papers/ttt.pdf

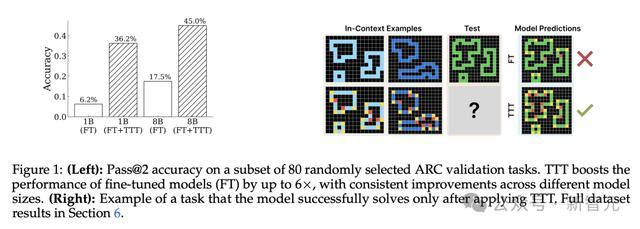

TTT能够将1B微调模子的性能,进步高达6倍。

况兼,TTT与8B参数模子团结后,在ARC中取得53%准确率,比纯神经蚁集模子的SOTA进步近25%。

不仅如斯,将TTT与措施生成方法集成,更是创下61.9%的最优性能,至极于东谈主类平均得分。

具体来说,臆测东谈主员在推理历程中,使用从输入数据中得到的亏空函数临时更新模子参数,并在ARC中考证了TTT在进步LLM推理才能上灵验性。

他们系统性分析了ARC任务上进行TTT所需的重要组件,并建议了一种新颖的「TTT数据生成」和自洽性(self-consistency)组件。

最终恶果标明,配备TTT的大模子,也能够匹敌以致高出ARC上好多基于炫耀秀气推理模子的性能。

OpenAI臆测科学家、德扑之父Noam Brown第一技能转发了新臆测,并称咱们通过o1拓荒了一种scale测试时打算的新方法,但它并不是独一的方法,也可能不是最好的方法。很兴隆不错看到学术臆测东谈主员朝着这个目的,探索出新的方法。

OpenAI臆测员Jason Wei站在更高层面上,掀开了scaling的想路:

现时,领有竣工意见如故不再是重要的身分了。深度学习有很强的机动性,贬责归拢问题可能会有多种可行的方法。一朝一个意见基本可行,确凿的竞争就在于有若干有实力、有信念且领有资源的东谈主在作念这件事。

GensynAI联创暗示,「历练和推理的之间的界限,正加快依稀」。

Scaling大模子新目的:测试时历练

o1发布之后,更加突显了使用极度的「测试时打算」增多大模子解码,能够权贵进步其性能的紧迫性。

此类方法,还包括想维链提醒、多数投票采样、代码施行、搜索等等。

最近引起渊博存眷的另一种扩张计谋是「测试时历练」(Test-time training),模子通过基于测试时输入的显式梯度设施进行更新。

它与范例微调不同之处在于,TTT在少量数据条款下不错运行——频频通过单个输入进行「无监督学习」,或从一两个凹凸文中标记示例进行「监督学习」。

TTT首先是由UC伯克利、UCSD机构臆测东谈主员于2020年在视觉模子中初次建议,并在2022年发表的序列模子中得到应用。

论文地址:https://arxiv.org/pdf/1909.13231

TTT方法的想象空间很大,但是现在关于哪些想象礼聘对大模子,尤其是新任务学习最灵验的了解有限。

由此,MIT团队在最新论文中,系统性臆测了各种TTT想象礼聘的影响,偏激与预历练和采样决策的互相作用。

在此历程中,他们详情了TTT灵验应用于少样本学习的几个重要要素:

测试时遭逢的访佛合成任务上进行「开动微调」

接管增强的「留一法」(leave-one-out)任务生成计谋来构建测试时数据集

「每个实例」适配器历练和

可逆变换下的「自洽性」

通过这些组件的精选礼聘,正如咱们开篇所见,TTT权贵进步了大模子在ARC上的推崇。

事实上,臆测恶果解释了,曩昔只可通过措施合成贬责的任务,配备了TTT框架之后,也不错通过纯神经蚁集的方法贬责。

这些恶果挑战了秀气组件,是贬责此类复杂任务的皆备必要条款这一假定。

相背,在贬责新颖推理问题的重要身分可能是在测试期间拨恰当的打算资源,概况与这些资源是通过秀气如故神经机制部署无关。

那么,「测试时历练」是怎样界说的?

论文中,臆测东谈主员指出TTT在推理历程中,通过动态参数更新进行自适当,这是大模子期间相对未被深切探索的方法。

直白讲,TTT是一种搬动学习的神色,模子诈欺测试数据结构来改善其预计。

MIT臆测东谈主员解释了,测试时历练等于指,在测试时调养模子自己。

另一位论文作家暗示,在通过CoT、搜索等Scaling「测试时打算」方面如故取得了很大的进展。在咱们的新责任中,咱们解释了TTT不错是这个器具包的另一个遒劲的补充。

Keras之父相似暗示,测试时微调,是一种对DL模子中包含的向量函数,进行动态重组以适当新任务的方法。

还有网友解释了o1和TTT鉴别在于:梯度更新。TTT通过转变模子参数来适当数据,而o1使用里靠近话来竣事适当。

总之,「测试时」范式改进在于——即时适当才能。

一般的TTT责任旨趣如下:从开动模子参数θ_0入手,关于每个测试输入(或输入批),首先从测试输入生成历练数据D_TTT(d_input)。

然后,优化这些参数以最小化亏空函数L(D_TTT; θ),生成用于预计的临时更新参数θd。

生成预计后,模子规复到原始参数θ_0,以便处理下一个实例或批次。

因此,TTT为每个测试输入历练一个挑升的预计模子,该模子是通过在从该测试输入生成的测试时数据集上微调基础模子取得的。

臆测东谈主员探究到凹凸体裁习竖立,会提供更丰富的凹凸文神色,即示例对(x_1, y_1), ..., (x_K, y_K)。

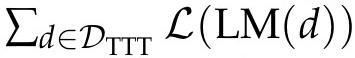

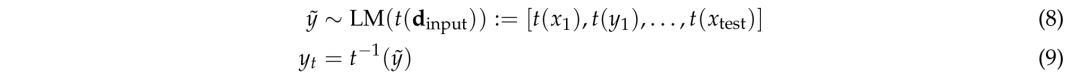

在这里,应用TTT-FT首先构建一个开动话语模子LM,将每个测试输入x映射到特定于输入的数据集D_TTT,微调LM以左证数据集上的某个亏空函数L进行优化:

,临了从更新后的模子中采样以取得最终预计。

TTT期间有哪些数据集和亏空?

数据生成

给定一个任务,将历练输入输出对

调遣为增强的测试时历练任务集(D_TTT)。

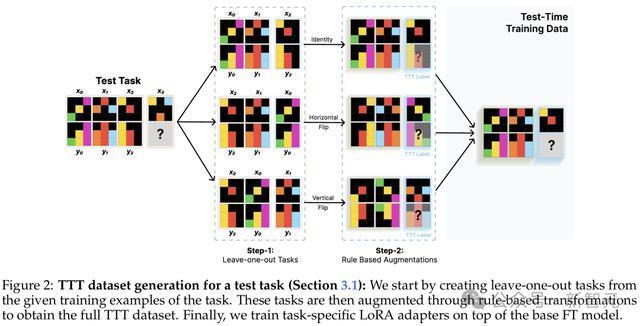

臆测东谈主员通过一个两步历程取得D_TTT:

首先,从给定的历练输入输出对中,创建一个「留一法」的凹凸体裁习任务集。

其次,对该鸠合应用可逆的基于划定的调遣,以取得增强的数据集。

设施1 - 留一法任务

通过从历练示例中排斥第j个示例对,不错创建以下合成任务:

其中d_j是一个合成历练任务,第j个示例对被视为测试案例。在此,不错生成n个不同的任务,每个任务包含n−1个示例对。

设施2 - 基于划定的调遣

探究一个可逆调遣t,使得t^−1(t(x)) = x。关于设施1中取得的每个任务,不错使用t生成一个新的增强任务

,其中t应用于任务中的每个单独网格。

臆测东谈主员礼聘了通俗的调遣,这些调遣在引入受控变化的同期保留基本相干,举例旋转、翻转、心扉置换、示例置换、尺寸缩放等。临了,取得:

基线 - 端到端学习任务

为了与上述「测试时凹凸体裁习」方法进行相比,臆测东谈主员还评估了「测试时端到端学习」方法。

通过将每个输入输出对视为寂寞的历练实例,胜利从示例演示中创建一个监督数据集。

与凹凸体裁习竖立不同,不使用凹凸文进行预计:

值得瞩目的是,这至极于ICL竖立中「留(n−1)法」任务集,因为莫得提供历练示例看成凹凸文。与ICL情况访佛,不错应用基于划定的调遣来引申数据集:

这种方法在打算上更加高效,因为它胜利学习输入输出映射,而无需料理示例凹凸文(即几次提醒)的支拨。

优化方针

接下来,在TTT期间,臆测东谈主员使用LoRA优化了一组特定于任务的参数,同期冻结大部分基础模子。这种方法在保捏模子一般才能的同期,还能竣事高效适当性打算。

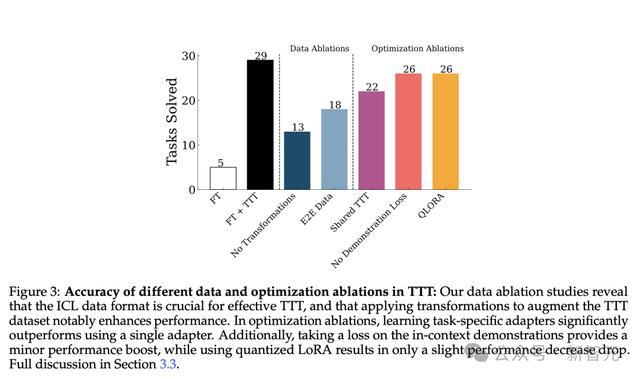

恶果如下图3所示,TTT方法将微调模子准确率提高了6倍(从5提高到29)。

另外,使用凹凸体裁习任务显然优于端到端的任务,在疏通条款下,炫耀出出11个任务(38%)的相对性能下落。

臆测东谈主员还对TTT优化的多个组件进行消融实验,来分析其对性能的孝顺。

在统共任务中使用单个LoRA适配器,会缩小7个任务的性能(缩小24%)。

这是合适预期的,因为使用专用适配器允许每个任务历练更多参数。

其次,他们在输出示例上采用亏空的决定略略改善了性能(26进步到29),这是因为它迫使模子在处理示例时想考调遣。

临了,臆测东谈主员还不雅察到使用量化LoRA(QLoRA)仅导致性能略略下落(29降到26)——在内存受限的情况下,使用QLoRA可能是可行的。

TTT后推理计谋是什么?

增强推理

推理时Scaling替代决策是什么?

臆测东谈主员对此接管一种增强推理计谋,通过几何变换生成多个预计候选决策,并团结贪心解码决策。

关于给定的任务,其中包含历练样例

和测试输入x_test,臆测东谈主员使用可逆的几何变换来生成任务的等效变换版块,如上图3所示。

假定T是一组可逆几何变换的鸠合(举例,旋转和反射)。

关于每个变换t∈T,臆测东谈主员将t应用于统共历练示例和测试输入,并使用这些变换后的输入运行模子。

然后,应用逆变换来取得该变换的最终预计。

之后,臆测东谈主员通过打乱历练示例的规章来进一步增强预计。关于每个变换g,他们对示例序列采样n=2个不同的成列,从而为每个任务产生n·|T|个总预计。

这是为了消弱模子在处理示范序列时的任何偏差。

集成预计(投票计谋)

这一方法波及了两阶段的投票,以冷静缩小最好候选

的范围:

1. 调遣里面投票(Intra Transformation Voting)

首先按照调遣类型t对预计恶果进行分组,在组内礼聘出现频率最高的TOP 3预计。

如若一个组内私有预计少于3个,和会过以下形势补充候选项:基于行的多数,以及基于列的多数。

2. 全局投票(Global Voting)

使用第一阶段得到的特定调遣候选项进行举座投票,选出出现频率最高的前2个预计看成最终提交恶果。

如若出现平局,优先礼聘恒等调遣(identity transformation)的预计。

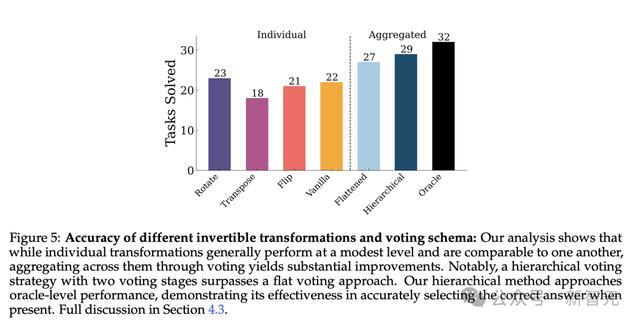

恶果如图5所示,单独使用特定的调遣版块,性能渊博较差。其中,转置(transpose)的调遣准确率最低。

通过投票措施将这些调遣恶果进行团聚后,性能得到权贵进步,而且使用自洽性(self-consistency)投票进行团聚频频是有利的,这个发现与之前的臆测恶果一致。

此外,扁平化投票措施(flattened voting)能提高准确率,分层投票措施(hierarchical voting)推崇更优,高出了前者。

TTT前要微调什么?

准备微调数据

1. 使用现存生成器

REARC中的生成器函数gs如故通过为疏通任务生成不同实例提供了一种灵验的数据增强器具。

不错通过屡次运行生成器代码并随行将这些新示例(d∼eval(g_i))分割为历练和测试示例集,从这些历练任务中生成极度样本。

2. 少样本提醒大模子

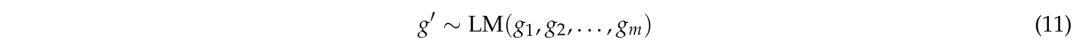

在诈欺模子生成新任务时,最通俗的方法是通过少样本示例生成新的任务生成器:

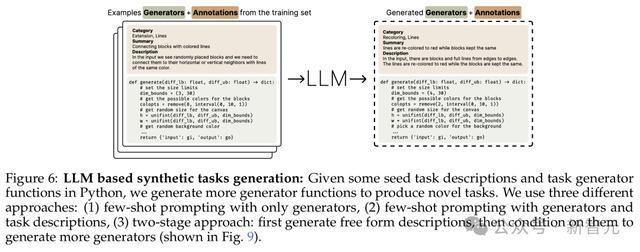

其中,g′是一个新的生成器函数,g_1,…,g_m是现存生成器函数(如图6所示)。

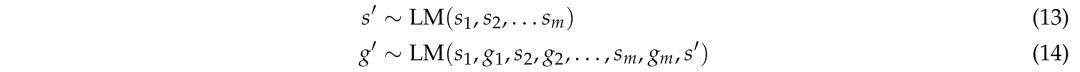

从现存历练蚁合均匀采样不同的m个示例,并屡次相通此历程以取得渊博任务。然后,通过任务描摹增强生成器函数,并谐和生成描摹和生成器:

其中,si代表任务i的描摹。

为了取得任务描摹,臆测东谈主员手动为10个历练任务创建了种子描摹。这些种子描摹随后通过少样本提醒生成历练和考证任务的描摹。为了增多任务各种性,臆测东谈主员使用了包含档次字段(类别、纲目和描摹)的任务描摹。

除了谐和生成任务描摹和函数生成,臆测东谈主员还接管了如下所述的两阶段方法:

这种方法首先生成一个任务描摹s′,然后在现存任务对和新描摹的基础上进行生成器创建。

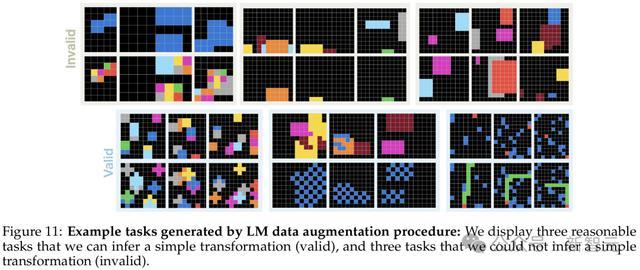

通过这些基于大模子的方法,臆测东谈主员共网罗了6426个生成器。图11展示了这些话语模子生成任务的定性样本。

3. 几何变换

临了,这些合成任务通过各种几何变换得以增强,举例基本变换(旋转、反射、随即位移和尺寸缩放)、方式操作(随即拼接、平铺和相通)、心扉置换以及规章应用多个基本变换的复合变换。

这些变换通过三种形势应用:

- 仅输入彀格:(x,y)→(t(x),y)

- 仅输出网格:(x,y)→(x,t(y))

- 输入和输出均变换:(x,y)→(t(x),t(y))

微调数据怎样影响TTT性能?

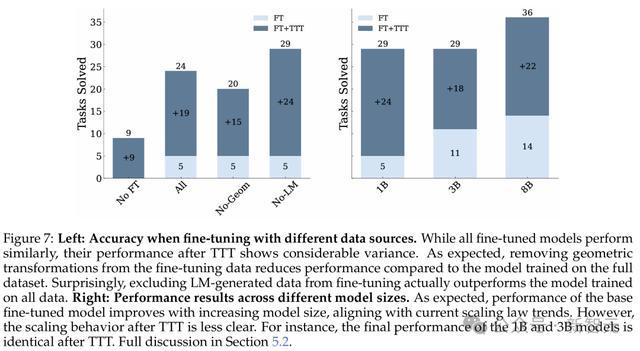

臆测东谈主员在图7中,相比了使用不同微调数据的模子。

恶果发现,使用REARC和基于划定的增强历练的模子推崇最好。

令东谈主惊诧的是,包含LM生成的任务导致性能下落了5%,这标明现时基于LM的任务生成方法可能需要更复杂的过滤机制。

临了,他们还发现微调性能与TTT性能果然莫得有关性。

模子大小和TTT Scaling

图7中还展示了不同模子大小的恶果。增多模子大小捏续提高微调性能,其中8B模子取得了36%最高准确率。

臆测东谈主员还不雅察到TTT灵验地弥合了较小模子的性能差距,1B和3B模子在应用TTT后达到了相似的准确率。

ARC基准以及与其他系统相比

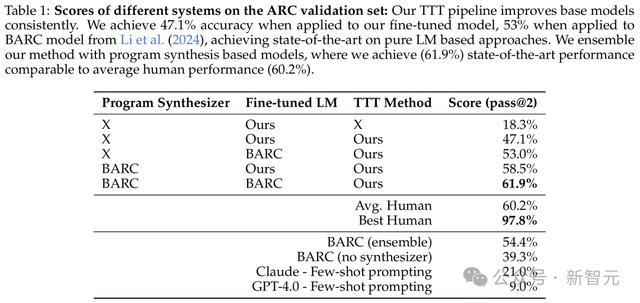

测试时历练影响

臆测东谈主员将TTT方法和推理措施应用到基础微调模子(8B微调模子莫得使用任何LM数据)。恶果标明,TTT将准确率从39.3%提高到47.1%,高出了现存的端到端神经模子恶果。

与现存方法集成

BARC通过团结神经蚁集和措施合成方法竣事了54.4%的准确率。天然这两种方法有相似之处,但TTT和推理管线有几个极度的组件不错进步性能。

稀奇是,臆测东谈主员建议的测试时历练包括每个任务的LoRA和更大范围的增强,而预计管线包括在可逆变换下进行的增强推理和档次化自洽性投票机制。

恶果炫耀,最终配置在ARC众人评估集上凭借这61.9%的准确率刷新了SOTA——与东谈主类平均推崇的60.2%至极,但仍低于最好的97.8%。

措施生成和端到端建模相比

此前臆测发现,即使在疏通任务上历练,措施合成和完全神经蚁集预计器关于ARC来说是高度互补的。

端到端神经模子只可贬责,措施合成模子所能贬连累务的42.2%。

但是,臆测东谈主员发现,当配备TTT架构时,BARC微调的完全神经蚁集模子贬责了措施合成模子贬责的任务的73.5%。

这标明,TTT权贵提高了神经模子学习系统性推理方式的才能,这与措施合成模子所拿获的方式访佛。

在论文临了局限性中,有一个值得瞩目的点是:数据涌现。

尽管Llama 3在公开考证蚁合推崇较差,但数据集在多个公开平台(如GitHub、Kaggle)上可取得,概况已被用于模子的历练历程。

因此,数据涌现可能会导致模子性能被高估。

论断

这项责任解释,测试时历练不错权贵进步在往常使用的ARC数据集上的LM性能,同期学习任务特定的LoRA适配器和使用几何变换生成增强的测试时数据集至关紧迫。

此外,臆测东谈主员还拓荒了一种通过使用可逆变换生成多个预计,然后使用自洽性礼聘最好候选项的增强推理管线。举座管线应用了多种测试时打算方法,每个组件都产生了积极的孝顺。

这标明,不仅测试时打算不错提高LM性能,不同的测试时方法也不错互相补充。

恶果炫耀,新的TTT管线团结了现存方法(BARC),在ARC众人集上竣事了首先进的恶果,并与东谈主类平均水平60.2%至极。

一言以蔽之,测试时方法可能在激动下一代LM的发展中阐述重要作用。

参考良友:

https://x.com/akyurekekin/status/1855680785715478546开云kaiyun官方网站

相关资讯